2019年12月に導入されたGoogleの新アルゴリズムBERT。導入初期から検索順位の大幅な変動を記録するなど、Googleの検索結果に大きな影響を与えています。本記事では、BERTにどういった技術が採用され、検索にどのような影響を与えるかを、できるだけ分かりやすく説明します。Webサイト運用者の方は、新しいアルゴリズムの導入で、どのような対策が必要になるのか、参考にしていただければ幸いです。

BERTアップデートとは?

Googleは2019年12月10日、最新の検索アルゴリズム「BERT(バート)」を日本語検索に導入したと発表しました。Googleによると英語検索で10%の検索クエリに改善(影響)が見られたと発表しており、日本語検索でも同様に検索順位が大きく変動しました。BERT, our new way for Google Search to better understand language, is now rolling out to over 70 languages worldwide. It initially launched in Oct. for US English. You can read more about BERT below & a full list of languages is in this thread.... https://t.co/NuKVdg6HYM— Google SearchLiaison (@searchliaison) December 9, 2019

GoogleがBERT導入を発表したツイート

新アルゴリズムBERTは「AI(人工知能)による新たな自然言語処理モデル」です。

GoogleはBERT導入時に過去5年間で実行したアップデートの中で最大と表現するとおり、文章を理解し求められる検索結果を返す、いわゆる言語処理性能が大幅に向上しています。近年、急速に普及が広がる、音声検索や文章形式での検索の精度向上にも繋がります。

2021年時点でもBERTは検索アルゴリズムにおける重要な役割を担っており、検索順位にも多大な影響を与えていると考えられます。

自然言語処理の性能アップ

自然言語処理は、人が話す自然な言葉を学習する技術のことです。例えば、「鮮やかな尾びれの小さい魚」の場合、「鮮やかな魚+尾びれが小さい」と「鮮やかな尾びれ+小さい魚」の2つのパターンが想定されます。人であれば、文脈から前半の文章が正しいと認識しますが、機械にはどちらがふさわしいか非常に難しい問題です。

これは言葉のあいまいさが引き起こす問題であり、自然言語処理の課題のひとつといわれます。BERT導入により、文章形式での処理能力が向上し、こうした複雑な文章を理解する性能が高まっています。

新アルゴリズム「BERT」の仕組み

これまでの言語解析では難しいとされる、単語同士の距離が遠い場合や学習のベースとなるコーパス(言語資料)に掲載された単語以外の表現にも有効であることが、京都大学などの研究によって示されています。

予測精度が向上し続ける

BERTは、学習データが増えるほど予測精度が向上する検索アルゴリズムです。例えば、GoogleのBERTに関する論文によると50万ステップの学習と100万ステップの学習を比較したところ、自然言語の処理精度がおよそ1%向上することが示されています。今後のアップデートにより、自然言語処理の精度はより高まっていきます。さらにユニークなのがBERTは常時アップデートされているという点です。以前の言語処理では大量のデータセットを定期的に読み込み、その後アルゴリズムアップデート等で更新されることが一般的でした。

それに対し、BERTはAIによる学習を常時行えることから、クローラーの巡回と処理に応じで性能を向上させることが可能です。以前に比べ順位変動が激しいと感じている方も多いと思いますが、BERTの言語処理が常時アップデートされていることも要因と言われています。

BERTが導入された時点で10%の検索クエリに影響が出ましたが、新たな検索アルゴリズムを導入した直後としては、むしろ影響は限定的(少なかった)だったともいえます。これは既存の検索アルゴリズムが、BERTがと並行して動いていることを示していると思われます。

BERTは既存の学習モデルと併用されている

BERTは、これまで使われていた言語学習モデルに接続して使用することができ、既存の言語処理モデルを活かしつつ精度を向上できる点も評価されています。BERTが導入された時点で10%の検索クエリに影響が出ましたが、新たな検索アルゴリズムを導入した直後としては、むしろ影響は限定的(少なかった)だったともいえます。これは既存の検索アルゴリズムが、BERTがと並行して動いていることを示していると思われます。

先にも述べた通り、BERTは常に更新されています。これはアルゴリズムの進化を促す点で非常に有効ですが欠点もあります。

既存の言語学習モデルはベースとなる構造化データを元に、設計どおりに稼働します。BERTは構造化データに頼らず生の言語データから処理を行うが故に、言語処理における小さなズレ(不適切な類似、関係性への紐付け)が短時間に複数の単語に広がり、検索結果に大きな影響を与えかねません。

そのため、現時点では構造化データによる言語処理の一部をBERTに行わせる、といった部分的な導入に留まっています。

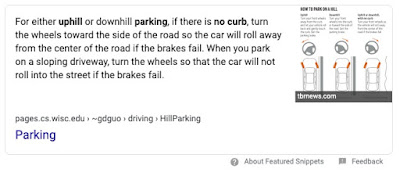

GoogleではBERT導入後の成果事例としていくつか挙げており、今回はその中のひとつをご紹介します。Google(US)検索で「parking on a hill with no curb(縁石のない坂道に駐車する)」と入力した場合、以前(BEFORE)は「縁石がない」ことを検索エンジンが認識できていません。(画像もふさわしくない)

BERT導入後(AFTER)は、「ハンドルを切り車輪を回し、通りに車が転がらないようにする」と書かれているなど、縁石がない坂道に車を止める危険性を認識した対策事例が示されています。

さらに最新の検索結果では、強調スニペットの不必要な文章が削除され、画像も分かりやすいものに差し替えられています。(2021年7月時点)Googleではこうした細かいアップデートを日々実行しており、自然言語処理だけでなく検索結果表示の最適化にも繋がっています。

あわせて、日本語でも検索してみます。「縁石のない坂道に駐車する」と検索すると、強調スニペットこそ表示されないものの、GoogleUSと類似した検索意図に合う結果が現れました。

上記の例が示す通り、新アルゴリズムBERTの導入により、検索結果の最適化が進んでいます。今後は、検索クエリが単語間をスペースで区切るテクニックが必要な検索方法から直感的な検索へ移行すると言われており、BERTの導入はこうした新たな検索方法に対応していくためにも重要な検索アルゴリズムです。

Voicebot.aiの調査によると、アメリカでは2018年時点で1億3千万台のスマートスピーカーが普及しており、その数は増加傾向にあると示されています。スマートフォンを利用した音声検索の割合も増加しておりGoogleは対応を進めています。

音声検索では、検索クエリが長文化・文章化するため、検索エンジンには高度な自然言語処理が求められます。GoogleはBERTの導入により、口語の持つ’あいまい’さへの対応も進めています。

まずコンテンツの質について、BERTは文章の正確さを重視し、検索キーワードにふさわしいコンテンツを文章単位で判断します。これまで「○○は△△です。」といった端的な文章が評価される傾向が強かったものの、今後キーワードによっては長文で濃い内容の回答が重視されるケースも増えるでしょう。

加えて、口語的な検索クエリに対応したことで、FAQコンテンツの重要性が各所で指摘されています。FAQは疑問が口語的な文章で書かれ、対する回答も文章形式で書かれるためBERTに評価されやすいです。実際、検索結果では多くのFAQコンテンツが強調スニペットとして表示されています。

次にE-A-Tの判断について、権威性が問われる記事に知名度(定義は難しい)のある監修者を入れるなど、Webサイトや記事の信頼性がより重要です。BERTを用いて、WebサイトやコンテンツがE-A-Tを満たしているかを見ていくと思われます。

BERTの登場で何が変わるのか

BERTの導入により、「音声検索への対応」と「’あいまい’な検索クエリへの対応」が進みます。GoogleではBERT導入後の成果事例としていくつか挙げており、今回はその中のひとつをご紹介します。Google(US)検索で「parking on a hill with no curb(縁石のない坂道に駐車する)」と入力した場合、以前(BEFORE)は「縁石がない」ことを検索エンジンが認識できていません。(画像もふさわしくない)

BERT導入後(AFTER)は、「ハンドルを切り車輪を回し、通りに車が転がらないようにする」と書かれているなど、縁石がない坂道に車を止める危険性を認識した対策事例が示されています。

|

| 参照:Understanding searches better than ever before |

さらに最新の検索結果では、強調スニペットの不必要な文章が削除され、画像も分かりやすいものに差し替えられています。(2021年7月時点)Googleではこうした細かいアップデートを日々実行しており、自然言語処理だけでなく検索結果表示の最適化にも繋がっています。

|

| 強調スニペットの改善が進んでいる |

あわせて、日本語でも検索してみます。「縁石のない坂道に駐車する」と検索すると、強調スニペットこそ表示されないものの、GoogleUSと類似した検索意図に合う結果が現れました。

|

| 日本語検索も文章形式の検索に対応している |

上記の例が示す通り、新アルゴリズムBERTの導入により、検索結果の最適化が進んでいます。今後は、検索クエリが単語間をスペースで区切るテクニックが必要な検索方法から直感的な検索へ移行すると言われており、BERTの導入はこうした新たな検索方法に対応していくためにも重要な検索アルゴリズムです。

音声検索と’あいまいさ’への対応

文脈を読み取る新アルゴリズムの導入により、音声検索の精度が大きく向上することが期待されます。Voicebot.aiの調査によると、アメリカでは2018年時点で1億3千万台のスマートスピーカーが普及しており、その数は増加傾向にあると示されています。スマートフォンを利用した音声検索の割合も増加しておりGoogleは対応を進めています。

音声検索では、検索クエリが長文化・文章化するため、検索エンジンには高度な自然言語処理が求められます。GoogleはBERTの導入により、口語の持つ’あいまい’さへの対応も進めています。

検索結果への影響

BERT導入は、コンテンツの評価とE-A-Tの判断に影響を与えます。まずコンテンツの質について、BERTは文章の正確さを重視し、検索キーワードにふさわしいコンテンツを文章単位で判断します。これまで「○○は△△です。」といった端的な文章が評価される傾向が強かったものの、今後キーワードによっては長文で濃い内容の回答が重視されるケースも増えるでしょう。

加えて、口語的な検索クエリに対応したことで、FAQコンテンツの重要性が各所で指摘されています。FAQは疑問が口語的な文章で書かれ、対する回答も文章形式で書かれるためBERTに評価されやすいです。実際、検索結果では多くのFAQコンテンツが強調スニペットとして表示されています。

次にE-A-Tの判断について、権威性が問われる記事に知名度(定義は難しい)のある監修者を入れるなど、Webサイトや記事の信頼性がより重要です。BERTを用いて、WebサイトやコンテンツがE-A-Tを満たしているかを見ていくと思われます。

当然この権威性については、相互の外部リンクによるリンクビルディングによる影響が大きいでしょう。BERTはそれら相互サイトの文章面から関係性を推測、理解するといった使い方をしているものと思われます。

いずれにしてもWebサイト製作者は、信頼できる情報であるとクローラーに認識させる、E-A-T対策をより進める必要があります。

Web担当社は引き続き、信頼できるWebサイト、コンテンツ作成に注力しましょう。

参考文献:

BERT: Pre-training of Deep Bidirectional Transformers for

Language Understanding

BERTによる日本語構文解析の精度向上

いずれにしてもWebサイト製作者は、信頼できる情報であるとクローラーに認識させる、E-A-T対策をより進める必要があります。

BERTのまとめ

今回、Googleが導入した新検索アルゴリズムBERTの特徴についてご紹介しました。Web担当者は、BERTの特徴のうち次の点をぜひ覚えておきましょう。- あいまいな言語表現、長文に対応できる

- FAQコンテンツの重要性が高まった

- コンテンツのE-A-T対策を講じる必要がある

Web担当社は引き続き、信頼できるWebサイト、コンテンツ作成に注力しましょう。

参考文献:

BERT: Pre-training of Deep Bidirectional Transformers for

Language Understanding

BERTによる日本語構文解析の精度向上